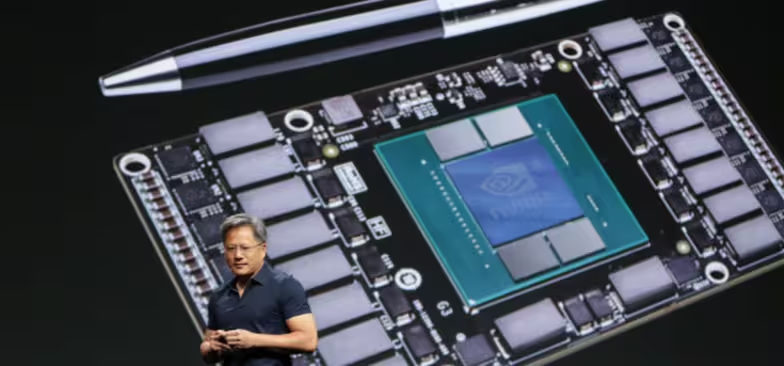

Los rumores de los últimos meses sitúan el próximo Computex que se celebra del 31 de mayo al 4 de junio como el momento en el que tanto AMD como Nvidia van a presentar la alineación de nuevas tarjetas gráficas de consumo. Mientras tanto, esta semana Nvidia ha presentado finalmente la arquitectura Pascal.

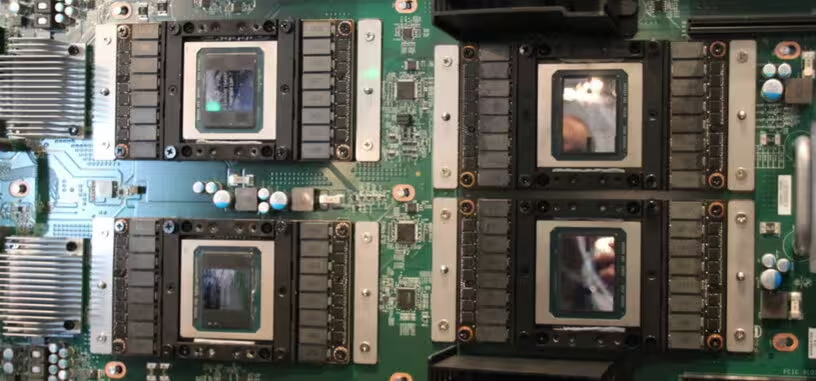

Lo ha hecho durante la presentación de la tarjeta gráfica para computación de alto rendimiento Tesla P100, que incluye el chip GP100 totalmente desbloqueado con 3.584 sombreadores y una impresionante frecuencia de reloj de 1480 MHz. Es una subida frente a los 3.072 núcleos CUDA y 1114 MHz del chip GM200 (Maxwell 2) utilizado en la Tesla M40 y la GTX 980 Ti. El GP100 estará disponible a nivel comercial en junio con el servidor de 129.000 dólares DGX-1.

La arquitectura y potencia de la Tesla P100 orienta hacia dónde se dirige la arquitectura Pascal: mejorar consumos al reducir a un nodo de 16 nm, pero mejorar la potencia subiendo las frecuencias. Las gallinas que salen por las que entran, y de Pascal se puede esperar un consumo similar con más rendimiento. Si bien queda la incógnita de qué va a ocurrir con los sombreadores asíncronos de DirectX 12.

En este caso algunos cambios de la arquitectura Pascal están orientados a mejorar el procesamiento paralelo por lo que no tengo mucha duda de que tiene soporte a ellos. Y aunque no los tuviera, si Nvidia mejora la potencia de Pascal mediante subidas de frecuencias y núcleos ese 10 a 20 % que le separa de las tarjetas gráficas de AMD en el terreno de las DirectX 12, en la práctica tampoco se necesitaría implementarlos.

Personalmente lo que veo cada vez más claro es que las mejoras de arquitectura GCN de AMD no van a ir mucho más allá que de pulido y reorientación a las gráficas de 2017 con nueva arquitectura, y que la única mejora sustancial es rebajar el proceso de fabricación a 14 nm para reducir notablemente el consumo de sus tarjetas gráficas. También seguramente con una subida de frecuencias. Pero en ambos casos, tanto AMD como Nvidia usarán sobre todo GDDR5, a la que le queda todavía mucha vida gracias también a GDDR5X.

Tecnología

-

Qué es una SSD o unidad de estado sólido: componentes, tecnologías y tipos

04 abr 2016 -

Así aterrizó por tercera vez el cohete reutilizable New Shepard

04 abr 2016 -

Nvidia presenta la tarjeta Tesla P100 y la arquitectura de las gráficas Pascal con HBM2

05 abr 2016 -

Este pequeño vídeo muestra el menú de inicio de Windows 10 que llegará en verano

06 abr 2016 -

Ya disponible en España el sobremesa para juegos Asus G11

08 abr 2016 -

Los habituales problemas con una nueva versión de drivers ahora es publicidad contra Nvidia

04 abr 2016 -

Una Raspberry Pi en una carcasa de una Game Boy es el emulador retro perfecto

07 abr 2016 -

Las Radeon R9 490 y 490X llegarían en junio

07 abr 2016 -

Huawei P9 y P9 Plus, diseño y gran hardware con doble cámara trasera

06 abr 2016 -

Asus publica un vídeo del ROG GT51, sobremesa para SLI de Titan X para juegos a 4K

07 abr 2016 -

AMD pondría a la venta la Radeon Pro Duo el 26 de abril

08 abr 2016 -

El servidor Nvidia DGX-1 incluye 8 Tesla P100 y cuesta 129.000 dólares

06 abr 2016 -

EVGA presenta sus tarjetas GTX 950 de bajo consumo

06 abr 2016 -

Nvidia muestra su prototipo de pantalla que funciona a 1.700 Hz para realidad virtual

07 abr 2016 -

Tesla Motors se ve saturada por las 325.000 reservas del Model 3

07 abr 2016 -

Apple patenta un teclado sin teclas para los MacBook

09 abr 2016 -

Un nuevo tipo de magnetismo podría impulsar la computación cuántica

07 abr 2016 -

WhatsApp mejora su seguridad con encriptación de extremo a extremo

05 abr 2016 -

¿Carcasa de metal o plástico? LG responde a la polémica sobre la carcasa del G5

05 abr 2016 -

G.Skill presenta un nuevo kit de memoria DDR4-3600 CL15 de 16 GB

09 abr 2016

Videojuegos

-

Los nuevos videojuegos de la semana (4 a 10 de abril)

04 abr 2016 -

Así funciona la retransmisión de juegos de PlayStation 4 a PC

07 abr 2016 -

Juega al primer The Legend of Zelda desde el navegador de tu ordenador o teléfono

04 abr 2016 -

Rumores sitúan a God of War 4 repartiendo tortas entre la mitología nórdica

05 abr 2016 -

Nintendo abre su tienda online de merchandising en España

06 abr 2016 -

El juego remoto de PlayStation 4 llega a Windows y OS X

05 abr 2016 -

Tracer protagoniza el segundo corto animado de Overwatch

04 abr 2016 -

¿Bricomanía en Fallout 4 ? No, es el tráiler del próximo DLC Wasteland Workshop

07 abr 2016

Cine y cultura

-

Batman v Superman: el amanecer de la justicia es una gran ocasión perdida

08 abr 2016 -

Disney presenta el primer tráiler de avance de Rogue One: una historia de Star Wars

07 abr 2016 -

Los trailers de la semana: selvas, fantasmas, superhéroes, Alicia y Pelé

03 abr 2016 -

Marvel prepara una serie de televisión de Capa y Puñal

08 abr 2016 -

Netflix se encontraría en negociaciones para producir la película Death Note

07 abr 2016 -

La adaptación de Mi amigo el gigante de Spielberg cuenta con nuevo tráiler

07 abr 2016 -

La BBC presenta a los actores de Class, la nueva serie derivada de Doctor Who

05 abr 2016 -

Lucasfilm vuelve a lanzar su evento de caridad Force for Change

06 abr 2016