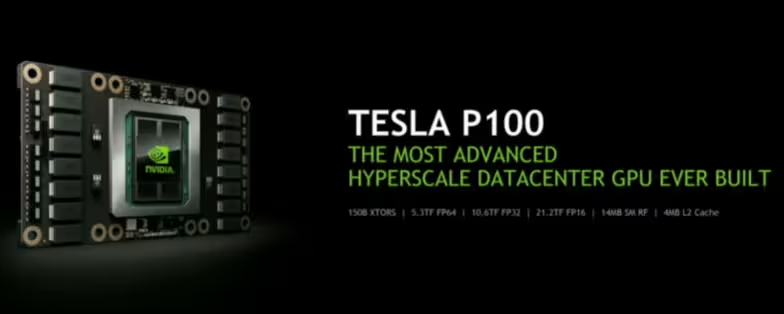

Nvidia ha llegado al Congreso de Tecnologías de GPU (GTC) con varias sorpresas bajo el brazo, aunque ya avanzo que ninguna de ellas tiene que ver directamente con sus tarjetas gráficas de consumo. Indirectamente sí, puesto que con la presentación de la nueva Tesla P100 ha arrojado luz sobre la arquitectura Pascal.

El chip usado para esta tarjeta es el nuevo GP100, fabricado a 16 nm, y que utiliza 16 GB memoria de tipo HBM2. Esta memoria es la revisión de la incluida en las tarjetas gráficas con chip Fiji de AMD, que en realidad fue el gran promotor de este nuevo estándar aunque es Nvidia el que va a usar una versión que realmente mejora significativamente con respecto a la GDDR5.

El chip GP100 incluye 3.584 núcleos CUDA, 512 más de lo que permitía el GM200 usado en las mejores tarjetas gráficas Maxwell2, como por ejemplo la GTX 980 Ti. A falta de que sea confirmado, sería lógico que la equivalente GTX 1080 Ti también contara con un GM200 desbloqueado, usando HBM2, y viendo el resto de características podría suponer a ojo una mejora de rendimiento del 15 al 20 %. Toca esperar a ver las mejoras reales de la propia arquitectura Pascal.

La velocidad base también mejora de 948 MHz a 1328 MHz, con un turbo de 1480 MHz, una mejor muy sustancial, y que justifica los 300 W de consumo que tiene esta tarjeta, incluso estando fabricada a 16 nm. Incluye 56 multiprocesadores de flujos de datos o SM (stream multiprocessors) frente a 24 del GM200, por lo que apuntaría a que en el frente del procesamiento paralelo hay mejoras muy sustanciales y puede haber sorpresas (desagradables para AMD y en realidad malas para los consumidores) en el terreno de los polémicos sombreadores asíncronos.

La arquitectura de un chip Pascal sigue la de Maxwell, compuesta por clústeres de procesamiento gráfico (GPC), los SM y controladores de memoria. El chip GP100 está dividido en seis GPC de hasta diez SM cada una, y ocho controladores de memoria de 512 bits para comunicarse con la memoria HBM2 que tiene 4096 bits de ancho de bus. Por comparación, la HBM de los chips Fiji tiene 1024 bits.

En esta ocasión cada SM se ve reducido a 64 núcleos CUDA, aunque como he comentado el número de SM se ha multiplicado, y cada SM está dividido en dos bloques de procesamiento. El objetivo de toda esta subdivisión, manteniendo una arquitectura similar, es aumentar la potencia de procesamiento paralelo de los núcleos CUDA, permitiendo una mayor granuralidad de las operaciones.

También se mejora el acceso de los hilos de procesamiento a los registros (que en total aumenta a 65.536 por bloque, duplicándose con respecto a Maxwell) y otras partes de la arquitectura del chip. Todo mejorado por disponer de una memoria con un bus de 4096 bits, que no hay que perderlo de vista porque es uno de los factores que pueden introducir retardos a la hora de realizar operaciones que requieren de inmediatez (como la realidad virtual). El chip PM100 permite un ancho de banda total de 720 GB/s, 208 GB/s más que el chip Fiji de AMD.

La potencia de procesamiento en coma flotante será de 10,6 TFLOPS FP32, con una conversión 1:2 para coma flotante en doble precisión (FP64) con lo que tendrá una potencia de 5,3 TFLOPS, y en media precisión será de 21,2 TFLOPS (FP16). Este último aspecto, la potencia a FP16, es importante para la computación en redes neuronales, hacia donde también está situando Nvidia esta tarjeta.

Posee también todas las características de computación de alto rendimiento (HPC), como la memoria con corrección de errores (ECC) a todos los niveles, incluida la caché. Estas tarjetas se conectan mediante Mezzanine, un tipo de conector para insertado en paralelo en vez de en perpendicular como los PCIe.

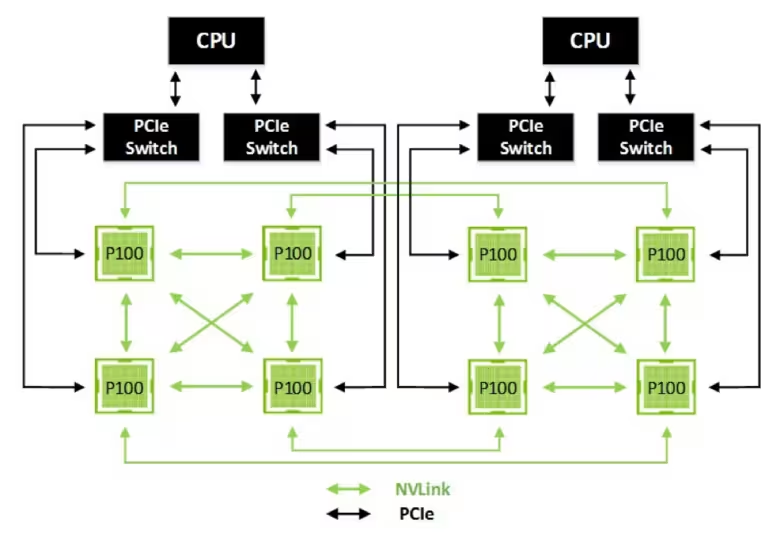

El último aspecto importante de la Tesla P100 es que cuenta con conexiones NVLink. Se usa para la computación acelerada por GPU, que llegará en todas las gráficas que usen en GP100. NVLink mejora la conexión entre las GPU y entre una GPU y la memoria principal del sistema. La conexión NVLink será una conexión especial a realizar entre las tarjetas, que permitirá hasta 40 GB/s bidireccionales, frente a 1 GB/s que permite cada pista de PCIe 3.0, y se pueden agregar cuatro enlaces para un total de 160 GB/s.

La Tesla P10 estará disponible en junio a través del sistema Nvidia DGX-1 que venderá directamente Nvidia a los interesados. Por tanto para entonces también debería estar disponible alguna otra tarjeta de Nvidia que use el GP100. A principios de 2017 otros fabricantes podrán vender sus propias soluciones que utilicen esta tarjeta gráfica.

| Tesla K40 | Tesla M40 | Tesla P100 | |

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) |

| SM | 15 | 24 | 56 |

| TPC | 15 | 24 | 28 |

| FP32 CUDA Cores / SM | 192 | 128 | 64 |

| FP32 CUDA Cores / GPU | 2880 | 3072 | 3584 |

| FP64 CUDA Cores / SM | 64 | 4 | 32 |

| FP64 CUDA Cores / GPU | 960 | 96 | 1792 |

| Frec. base | 745 MHz | 948 MHz | 1328 MHz |

| Frec. turbo | 810/875 MHz | 1114 MHz | 1480 MHz |

| FP64 GFLOPS | 1680 | 213 | 5304[1] |

| Uds. textura | 240 | 192 | 224 |

| Interfaz memoria | 384-bit GDDR5 | 384-bit GDDR5 | 4096-bit HBM2 |

| Memoria | Hasta 12 GB | Hasta 24 GB | 16 GB |

| Caché L2 | 1536 KB | 3072 KB | 4096 KB |

| Tamaño registros / SM | 256 KB | 256 KB | 256 KB |

| Tamaño registro / GPU | 3840 KB | 6144 KB | 14336 KB |

| TDP | 235 Watts | 250 vatios | 300 vatios |

| Transistores | 7.100 millones | 8.000 millones | 15.300 millones |

| Tamaño chip | 551 mm² | 601 mm² | 610 mm² |

| Proceso fabricación | 28-nm | 28-nm | 16-nm |

Vía: Nvidia, Nvidia (2).