Con la llegada al mercado (más o menos) de la RTX 3080 la mirada está puesta ahora la RTX 3090 que llega el 24 de octubre. Con la actualización de los controladores GeForce para mover el chip GA102 que incluyen ya han empezado a llegar supuestas pruebas de rendimiento de la RTX 3090, y aunque hay datos muy variopintos, que van desde un 20 % más de rendimiento a solo un 5 % más, lo que debería estar claro es que sobre el papel no parece que vaya a merecer la pena pagar los 800 euros de diferencia entre ambas.

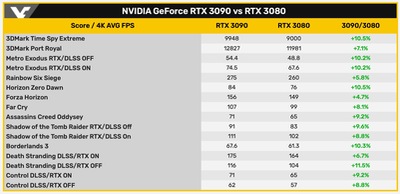

También he insistido desde hace un tiempo en que los procesadores actuales no iban a estar preparados para la potencia de las RTX 3080 y 3090, y no es una exageración aunque como todo siempre depende del contexto. A altas tasas de refresco habrá problemas en algunos juegos y en otros no, por lo que va a ser bastante necesario acompañar a estas tarjetas de unos micros potentes. De lo que no he hablado desde hace bastante tiempo es de algo común a las arquitecturas de procesamiento paralelo como las de los chips gráficos usados hoy en día. Pero antes, ved la siguiente tabla con la diferencia de rendimiento entre las RTX 3080 y RTX 3090 en una serie de juegos y pruebas enlatadas.

La diferencia se sitúa sobre el 10 %, por lo que pagar más de un 100 % del precio de la RTX 3080 por la RTX 3090 no parece una decisión inteligente. Es posible que en algunas situaciones sí haya una diferencia del 20 %, que es la diferencia en sombreadores entre ambas tarjetas, y ciertamente los 24 GB de VRAM hacen que sea una tarjeta gráfica interesante para los que juegan mucho y hacen mucho diseño 3D. La RTX 3090 apunta a una tarjeta gráfica buena además para jugar a 8K y 60 Hz con DLSS activado como dice NVIDIA, por lo que es una tarjeta de nicho de mercado y lo cual me parece estupendo —que haya más variedad entre lo que elegir siempre está bien—.

El tema está en que entre la RTX 3090 y RTX 3080 hay una diferencia de sombreadores en torno al 20 % —10496 frente a 8704, un 20.5 % más para ser exacto— y funcionan a misma frecuencia de en torno a 1.7 GHz. Esa cosa que no menciono desde hace tiempo es que en las arquitecturas de fuerte paralelismo cuantos más núcleos más difícil es mantener a todos ocupados todo el tiempo. Si una unidad gráfica (GPU) tuviera 5000 núcleos y otra 10 000 funcionando a misma frecuencia, no se puede asegurar que la segunda funcionará siempre al doble de rendimiento que la primera. Por tanto cuantos más núcleos sumas a una GPU más rendimiento decreciente hay; o sea, que el beneficio de añadir un núcleo más es cada vez menor.

En parte se puede ver en la RTX 3080 que esto ya pasa con sus 8704 núcleos frente a los 4352 de la RTX 2080 Ti. En la mayoría de los juegos a FHD la mejora se puede quedar en torno a un 30-50% —incluso menos en algunos casos— aunque sean exactamente el doble de sombreadores, y a 4K se puede conseguir una mejora más clara entre ambas. Aquí hay factores adicionales que afectan como el procesador y que parte de los núcleos CUDA FP32 tienen que hacer ahora trabajo de INT32 que en Turing hacía las unidades INT32 específicas, pero aun así se aplica claramente ese rendimiento decreciente.

Aunque no hay todavía análisis fiables de la RTX 3090, que nadie espere que tenga un 20 % más de rendimiento en cualquier situación por esa terna de factores: procesador, trabajo INT32 y rendimiento decreciente de los CUDA. Es por lo que también vengo llamando a la RTX 3090 un caro pisapapeles, y por lo que se va viendo no parece que vaya a estar equivocado. A esta tarjeta la terminaré llamando el BFCP, porque al director ejecutivo le encanta ahora usar «BF» —big fucking, en referencia a la BFG 9000 de Doom— para todos sus productos. Esa sigla BFCP es de big fucking caro pisapapeles, y por una vez voy a dar por bueno el uso de anglicismos porque es en tono despectivo.

Pero, eso sí, este tema de escalado de las arquitectura paralelas también afectará a AMD y sus Radeon 6000. De hecho los problemas de rendimiento decreciente de los sombreadores siempre han afectado muchísimo a la arquitectura GCN de AMD, pero es de imaginar que en RDNA 2 los habrá resuelto —porque tenía varias formas de hacerlo—. Quedarán más disimulados por la mejora de rendimiento por vatio y otros cambios, pero seguirán presentes. Pero al menos no serán unos BFCP.

Vía: Videocardz, Videocardz (2), Videocardz (3).