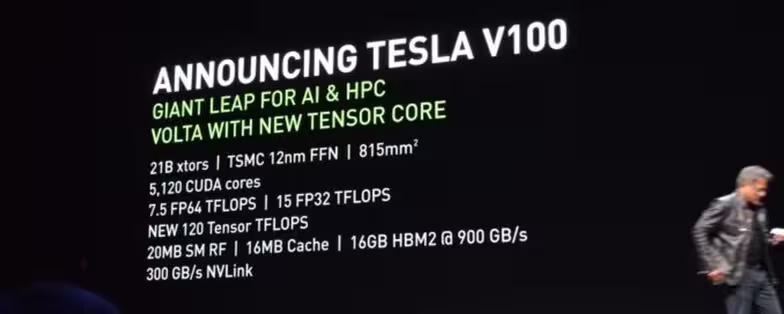

Nvidia ha llegado al GTC con su próxima arquitectura bajo el brazo en forma de la Tesla V100 para centros de datos. Esa arquitectura es la Volta, que según los rumores llegará en tarjetas gráficas GeForce durante el verano, retomando el ciclo de actualización anual previo a Maxwell. Esta tarjeta gráfica tiene una gran cantidad de logros técnicos, ya que en un tamaño reducido tiene una potencia de 15 TFLOPS, frente a los 11 TFLOPS de la GTX 1080 Ti actual.

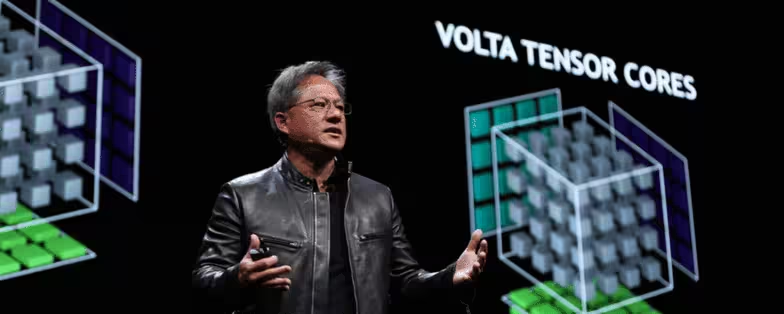

Aunque las GeForce tengan una arquitectura menos orientada a la inteligencia artificial como las Tesla, esta Tesla V100 incluye un nuevo núcleo de tensores —unidad algebraica compleja usada en la IA— y añade instrucciones TensorOP y formatos de datos relacionados a los CUDA para potenciar al máximo el rendimiento en este tipo de cálculos. Es la réplica a los TPU o unidades de procesamiento de tensores de Google.

La imagen superior es la Tesla V100 en formato tarjeta PCIe, de una sola ranura, y de longitud similar a otras tarjetas gráficas mini-ITX. El chip GV100 está fabricado a 12 nm con un proceso FinFET FFN, con una superficie total de 815 mm2. Utiliza un enlace NVLink de segunda generación de hasta 300 GB/s, utilizado inicialmente en la Tesla P100 a 160 GB/s, y está totalmente dirigido a servidores específicos. Dispone de 16 GB de memoria HBM2 a 1.8 1.75 GHz, lo que le da un ancho de banda de 820 900 GB/s.

Lo importante de esta tarjeta es lo que he indicado anteriormente, su potencia de cómputo de tensores. Si bien la potencia de cálculo genérica es de un 50 % más que frente a Pascal, en el cálculo de tensores aumenta un 1200 %. Eso hace que esta Tesla V100 tenga una potencia de cómputo de 120 TTFLOPS —TFLOPS de tensores—.

El chip dispone de 5120 núcleos CUDA y 16 MB de caché, y su desarrollo de la arquitectura le ha costado a la compañía 3000 millones de dólares. Según Nvidia, los gráficos que se necesitaba minutos para renderizarlos con una Titan X Maxwell ahora se necesitarán solo segundos con este nuevo chip Volta.

El primer producto con esta Tesla V100 será un nuevo servidor basada en el DGX-1 y que se llamará simplemente DGX-1V y que está orientado a la supercomputación. El servidor incluye ocho Tesla V100 con una potencia total de 120 TFLOPS o 960 TTFLOPS. Su coste será de 149 000 dólares, se puede ya reservar y se enviará a los compradores en el tercer trimestre. También habrá una DGX personal de 480 TTFLOPS por 69 000 dólares.

Siguiendo con la potencia de computación, gracias a TensorFlow y TensorRT —un entorno en tiempo de ejecución para cálculo de tensores— se acelera el entrenamiento de las IA en un 1200 % y las inferencias que realizan —entender lo que ven por ejemplo en imágenes— en un 600 %. Son cifras bastante impresionantes, comparadas con lo que se puede conseguir con Pascal.

El esquema general de este chip es el siguiente, y Nvidia lo ha mostrado para incidir en que el procesador Tegra Xavier hace uso de la arquitectura. Está incluido en Drive PX, la placa para conducción autónoma de Nvidia, y que va a ser utilizada por los principales fabricantes de coches, como Toyota, para sus vehículos autónomos. Con la potencia que tiene esta arquitectura en el terreno de la inteligencia artificial, Tegra Xavier va a ser un gran SoC para los vehículos.

Nvidia también ha anunciado que la aceleradora de aprendizaje profundo (DLA) de Xavier va a ser compartida como código abierto. La compañía quiere ante todo que el mundo progrese en el sector de la inteligencia artificial, y la mejor forma de hacerlo es compartir una parte de lo que han conseguido hasta el momento.

Vía: AnandTech.