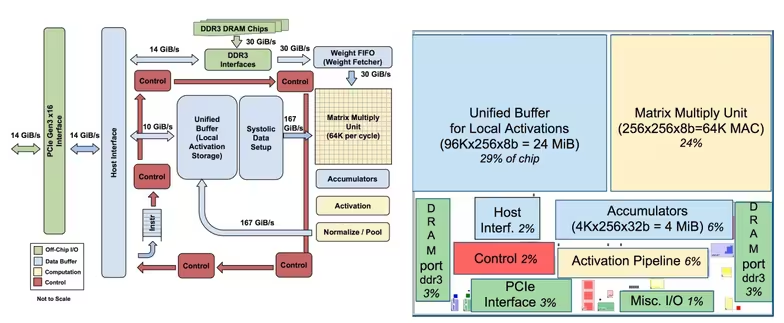

Google presentó hace algo menos de un año un chip que tenía en desarrollo para realizar tareas concretas de inteligencia artificial como es el cálculo de tensores, una entidad algebraica no demasiado conocida. Estos chips tienen el nombre de unidades de procesamiento de tensores —TPU, por sus siglas en inglés—, y ahora ha decidido compartir un poco más de información sobre ellos.

Los investigadores de Google han publicado un artículo académico o paper sobre las TPU. Una TPU es capaz de realizar inferencias de aprendizaje automático de 15 a 30 veces más rápido que un procesador Intel o una tarjeta gráfica de Nvidia. Google indicó el año pasado que están siete años por delante en este tipo de cálculos que los actuales procesadores, y según lo indicado razón no le falta.

Además, el consumo de estos chips es muy inferior, consiguiendo entre un 30 a un 80 % de más rendimiento por vatio, por lo que son mucho mejores para centros de datos. Este menor consumo procede de que en la práctica son ASIC, o circuitos integrados creado para una tarea específica.

La compañía empezó a explorar en 2006 el uso de las FPGA y ASIC en los centros de datos, pero no ha sido hasta la explosión de la inteligencia artificial cuando se ha hecho evidente el gran potencial que tienen las TPU frente a los procesadores tradicionales.

Vía: TechCrunch.