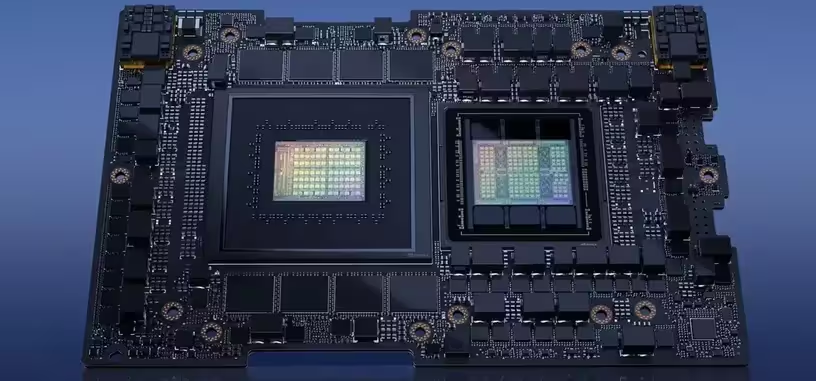

NVIDIA lleva bastante tiempo hablando de su chip Grace Hopper para cómputo, y ahora lo ha introducido formalmente en la Computex 2023. Es el «superchip» GH200, el cual viene a ser una tarjeta con una CPU de tipo Grace y una GPU H100 de arquitectura Hopper. Los chips están fabricados con un proceso litográfico de 4 nm por TSMC, y está totalmente pensado para cargas de inteligencia artificial.

La parte de CPU incluye 72 núcleos Neoverse V2 y puede ir acompañada de hasta 480 GB de memoria LPPDR5X con código de corrección de errores. La parte de GPU es de arquitectura Hopper, con 132 multiprocesadores de flujos de datos que se traducen en 16 896 sombreadores, además de dispone de 528 núcleos tensoriales.

Ese chip Hopper puede contener en su encapsulado hasta 96 GB de HBM3 con un ancho de banda de hasta 4 TB/s. La comunicación entre CPU y GPU se realiza por una interconexión NVLink 4 de 900 GB/s. El conjunto de este superchip tiene una potencia de diseño térmico (TDP) que va de los 450 W hasta los 1000 W según la configuración.

Este superchip es la esencia de la supercomputadora DGX GH200 para inteligencia artificial, la cual está compuesto de 256 chips GH200, con 120 TB de memoria LPDDR5 y 24 TB de HBM3. La potencia de cómputo en inteligencia artificial es de 1 exa-FLOP a FP8. La DGX GH200 está compuesta por 24 bastidores como se ve en la imagen de arriba, todos interconectados usando los equipos de red de NVIDIA que obtuvo con la compra de Mellanox, ahora una filial conocida como NVIDIA Networking.

La idea detrás de esta supercomputadora es la de proporcionar a empresas un equipo completo para el entrenamiento de modelos grandes de lenguaje (LLM), que son las redes neuronales que están detrás de las inteligencias artificiales generativas como ChatGPT o Bard.

Vía: AnandTech.