Micron ya avanzó la llegada de la GDDR6X hace solo unas pocas semanas en un documento interno en el que también aparecía referenciada la RTX 3090 que se ha hecho realidad. Ahora la ha anunciado oficialmente, y en principio la compañía la está proporcionando a Nvidia en chips de 8 Gb (1 GB) de capacidad, la cual tiene el habitual bus de 32 bits y funciona hasta a 19.5 Gb/s a 1.35 V.

El principal problema que hay en el aumento de la frecuencia, y ocurre en cualquier tipo de chip, es el de la estabilidad de la señal y, más importante aún, el de la forma en que se transfieren los unos y ceros. Puesto que un 1 es una tensión fija y un 0 son cero voltios, el problema llega a la hora de evitar que el envío de una ristra de unos seguida provoque un sobrecalentamiento del sistema.

La memoria GDDR hasta ahora usaba un algoritmo de no regreso a cero (NRZ) lo que significa que un 1 es representado por un valor de tensión generalmente positiva y un 0 por una negativa. Hay varios tipos de NRZ con diferentes formas de pasar entre unos y ceros, pero la idea básica es esa. Esto tiene problemas de distribución del voltaje en el tiempo, que queda representada su distribución en la siguiente transparencia como diagramas de ojo. Los voltajes quedan centrados en torno a dos valores, lo cual no favorece el consumo del sistema. Lo difícil en realidad es que los voltajes no varíen mucho y por tanto que parezcan líneas bien definidas en los cambios de estado, dejando ver un ojo o hueco bien definido.

La nueva GDDR6X cambia el código de línea por la modulación PAM4 (modulación por amplitud de pulsos de cuatro niveles), una vieja conocida para los telecos —hoy en día quizás os suena más «QAM» de la conectividad LTE y 5G, que es algo bastante más avanzado—. En lo que se basa PAM4 es en combinar los bits a enviar de dos en dos y a establecer por tanto cuatro niveles posibles de tensión para cada dupla (00, 01, 10, 11). Por un lado permite enviar más información por pulso —el doble, dos bits en en vez de uno—, pero también permite distribuir mejor el voltaje y por tanto también el consumo —no siempre va a llegar al valor máximo de voltaje de lo que en NRZ sería un 1—.

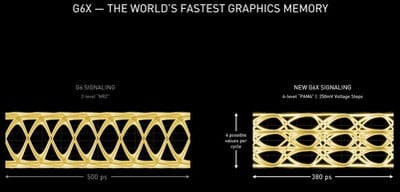

El paso de NRZ a PAM4 no duplica la tasa de transferencia de bits ya que se ralentiza en realidad un poco el envío de las duplas para asegurar la estabilidad de la señal —se tarda algo más en enviar dos bits en PAM4 que uno en NRZ—. Tiene en parte que ver con que se manejan márgenes de voltaje más estrictos y hay que asegurar que no se sobrepasan. Pero aún siendo «algo más lenta» en el cambio de voltaje que NRZ se consigue mejorar el ancho de banda total con una reducción de consumo, que es lo que se busca. En la transparencia se ve que se envían ocho bits en 500 ps con NRZ y ocho bits en 380 ps en PAM4, lo cual es un bit en NRZ cada 62.5 ps y una dupla en PAM4 cada 95 ps.

La dificultad de usar PAM4 en las memorias es que el diagrama de ojo quede con líneas compactas o un ojo bien definido, y lo que quiere decir eso es que haya poco ruido en el sistema y las transiciones no produzcan efectos adversos y siempre se haga a los valores de voltaje prefijados del sistema. El problema está en que el envío de señales a altas frecuencias producen siempre efectos adversos, resistencias adicionales y por tanto se necesitan circuitos de envío y recepción de la información mucho más difíciles de implementar.

Pero Micron ha conseguido implementarlos para la GDDR, y por tanto consigue esos 19.5 Gb/s a 1.35 V —una pequeña reducción en torno al 15 %, pero importante para conseguir hasta un 25 % cuando llegue la GDDR6X a 21 Gb/s—. Puesto que la distancia al procesador determina en gran medida el ruido tolerable por el sistema, es por lo que en las placas de circuito impreso de las RTX 30 veréis los chips de GDDR6 mucho más cerca entre sí y mucho más cerca de la GPU que en generaciones anteriores.

Además de su uso en tarjetas gráficas, Micron posiciona este tipo de memoria para los equipos de computación de alto rendimiento, visualización profesional e inteligencia artificial, por lo que no será algo exclusivo de Nvidia o AMD.

Vía: Guru3D.