NVIDIA ha renovado la H100 con un modelo H200 en el que prácticamente solo toca la parte de la memoria, aunque no es un apartado menor en las aceleradoras. Hay muchas tareas de cómputo que son muy intensivas de memoria, como por ejemplo los grandes modelos de lenguaje (LLM) que se crean para las IA como ChatGPT. NVIDIA ha avanzado el rendimiento de la B100 en la presentación de la H200, la cual será la aceleradora que anuncie en la primera mitad de 2024.

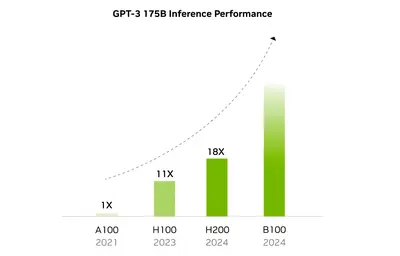

Tendrá la arquitectura Blackwell para cómputo, que es una arquitectura en la que prescinde de los sombreadores para centrarse en los núcleos tensoriales, por lo que son específicas de cómputo. Y sobre todo de inferencias, gracias a su diseño y al software que le acompaña desarrollado por NVIDIA. Por eso la siguiente imagen muestra la rápida evolución de rendimiento en GPT entre 2021 y 2024. Para el próximo año, la B100 va a duplicar el rendimiento de la H200, y triplicará el de la H100.

En otras tareas ya se verá qué aumento de rendimiento proporciona, pero teniendo en cuenta que el uso principal que se les está dando a estas aceleradoras es para entrenar inteligencias artificiales, sus modelos grandes de lenguaje, es en lo que NVIDIA, AMD e Intel se van a centrar para promocionar estas aceleradoras. La B100 tendrá un aumento de cantidad de memoria, otro requisito de los LLM, y su ancho de banda. Actualmente hay algunos LLM bastante limitados en precisión debido a la cantidad disponible de memoria que tienen las aceleradoras usadas para ellas.