Google ha estado trabajando duro para acelerar los cálculos para labores de inteligencia artificial con sus unidades de procesamiento de tensores o TPU. Por ello en el I/O 2017 ha presentado la segunda generación del chip, que tiene una potencia de cómputo de 45 TFLOPS a la hora de manejar tensores, y acelerar el entrenamiento de inteligencia artificial y las inferencias en el reconocimiento de objetos en fotos.

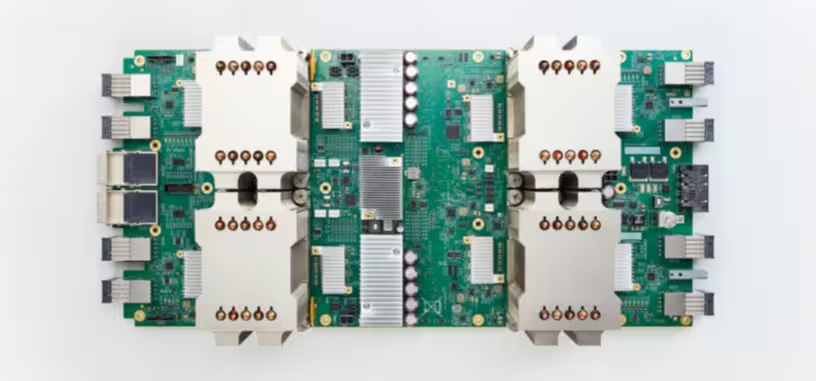

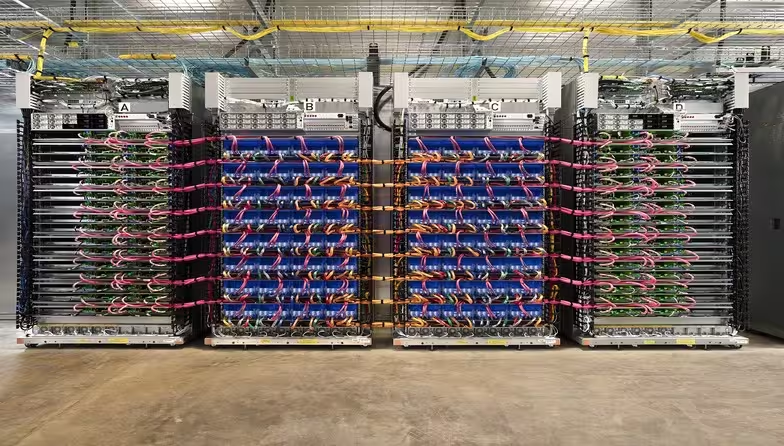

Google los va a permitir usar a terceros a través de sus nuevos centros de datos para inteligencia artificial dotados de ellos. Una tarjeta para servidores incluye cuatro TPU para un total de 180 TFLOPS, y se distribuyen a su vez en 16 por bastidor. Por último, cuatro bastidores de 2880 TFLOPS de potencia de cómputo tensorial conforman un pod o barquilla, que sería la estructura máxima de organización disponible para usar a través de Compute Cloud de Google en sus centros de datos. La potencia de estas barquillas es de 11 520 TFLOPS.

Nvidia presentó recientemente la Tesla V100, un chip gráfico que por sí solo tiene una potencia de 120 TFLOPS en cálculo tensorial, de tamaño bastante más reducido, por lo que quizás Google haya llegado tarde a la fiesta de los tensores, aunque estoy seguro de que será una solución mucho más barata que la de Nvidia. Son totalmente programables a través de TensorFLOW, un entorno de desarrollo de código abierto para inteligencia artificial disponible en GitHub.

Vía: Google.