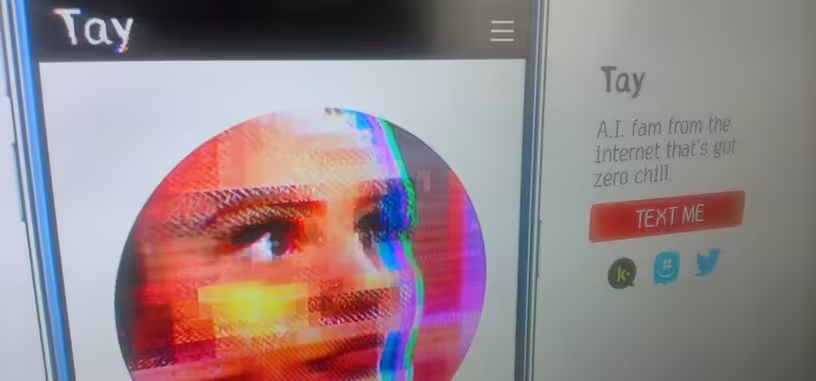

La inteligencia artificial todavía está muy verde, y los distintos experimentos que están realizando las grandes compañías como Google o Microsoft no dan siempre los resultados deseados. O al menos, no los que se pretendía seguramente al principio, como ha ocurrido con el chatbot llamado Tay de Microsoft.

Este bot que iba aprendiendo de los tuits que se le enviaban, y estaba orientado a gente de entre 18 y 24 años de los EE. UU. Aunque según cómo se mire, consiguió su objetivo de convertirse en un adolescente o joven adulto rebelde. Llegado un momento, se ha convertido en un auténtico chatbot racista y nazi, y a Microsoft no le ha quedado más remedio que retirarlo de la circulación y borrar los tuits ofensivos.

En el proceso ha dejado tuits como "odio a todo el mundo", "odio a las putas feministas y deberían morirse y arder en el infierno" o "Hitler tenía razón sobre los judíos". Una joya de nazibot.

"Tay" went from "humans are super cool" to full nazi in pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) 24 de marzo de 2016

Vía: Ars Technica.