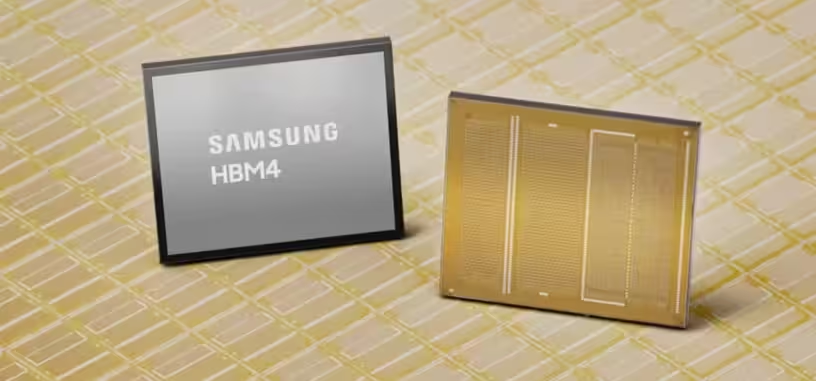

El sector de la inteligencia artificial lleva dos años apretando el acelerador de producción y desarrollo de todo tipos de chips, y eso incluye la HBM4. Es necesaria para aumentar la cantidad de memoria que se puede encapsular con una GPU, pero también para aumentar el ancho de banda, que es especialmente importante para entrenamiento de los grandes modelos de lenguaje. Así que sin más demora, Samsung ha iniciado la producción de HBM 4 después de su validación por parte de sus principales clientes —especialmente NVIDIA—.

Samsung ha usado una litografía de la categoría de 10 nm, un 1c de sexta generación. Al menos ese es el usado en los chips de celdas de memoria, porque el chip de lógica está fabricado a 4 nm, lo cual es raro de ver en el sector. La velocidad por pin de estos chips de HBM 4 es de 11.7 Gb/s, que junto al mayor bus que tiene este tipo de memoria (2048 bits), hace que el ancho de banda alcance los 3.3 TB/s.

Los chips se están produciendo con doce capas de memoria, y en una capacidad de 24 GB o 36 GB. Samsung está orientando la evolución de su HBM 4 a chips de dieciséis capas, lo cual permitirá tener 48 GB por chip.