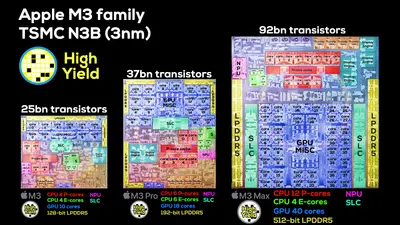

Apple ha anunciado su serie M3 de procesadores ARM y cuentan con algunos cambios importantes para la compañía de cara a establecer lo que será la serie M4. La actual serie es interesante, pero no suponen un gran aumento de potencia como para que los que tengan un Mac con un M1 o un M2 renueven su equipo. Ahora han anotado la planta de los chips con los bloques lógicos de los que se componen, lo cual da una visión más específica de lo que ha hecho en estos chips.

El M3 Pro, que ha reducido su tamaño y número de chips, está claramente orientado a reducir costes, aunque al final dé más rendimiento que el M2 Pro. No mucho más, como debería ser, pero menos da una piedra. Así se tiene su iGPU con un núcleo menos, o su parte de CPU con dos núcleos de rendimiento menos y dos de eficiencia más. Es un chip extraño, porque también recorta su bus de memoria de 256 bits a 192 bits, y por tanto con la misma LPDDR5-6400 su ancho de banda cae de 200 GB/s a 150 GB/s. Lo dicho, es un chip para recortar costes.

El chip M3 Max es más interesante y potente, sobre todo al ampliar a dieciséis los núcleos de CPU. El motivo es el buen salto de rendimiento de Intel y AMD, por lo que este chip no se puede quedar tan atrás como se estaba quedando el M2 Max. Mantiene el bus de 512 bits y su ancho de banda de unos 400 GB/s, ideal para la unidad gráfica integrada. Pero de esta, lo más importante es el cacheo dinámico que Apple ha promocionado como una gran revolución.

Ahora que está presentado, ha resurgido de la oficina de patentes estadounidense esta patente que data de 2020 y que ahora tiene más sentido. En ella, y otras relacionadas, se explica las ventajas del cacheo dinámico de información para la GPU, y lo consigue con circuitería específica para ello en el chip. Cubre distintos apartados de solicitud de memoria bajo demanda, que lleva a ese anuncio de la compañía de que la GPU de los M3 solo utiliza la cantidad de memoria justa y necesaria para las tareas que están ejecutando.

Sin esa circuitería el funcionamiento de usar la memoria como caché para los procesos de GPU pasa por el habitual proceso de reserva porque las cargas de GPU tienen tendencia a ser impredecibles. Si reservas de menos, produces problemas de latencia. Si reservas de más, entonces necesitas equipos mejores y eso supone un sobrecoste. Al final con la circuitería adecuada y unas tablas de asignación para el cacheo dinámico de la GPU se mejora el rendimiento global.

Normalmente lo hará porque no se va a reservar memoria de más, reduciendo a su vez los tiempos de acceso a la información, y permite a su vez aumentar la eficacia de la utilización del ancho de banda de memoria. Si no hay que hacer cosas colaterales como perder tiempo de más en buscar dónde está la información en la caché reservada o realizar una reserva adicional de memoria, eso permite reducir el uso de ancho de banda de memoria, mejora la utilización de la GPU al eliminar tiempos de espera de búsqueda de información, y en tareas más exigentes tiene a su vez más ancho de banda disponible. Ideal para tareas como las relacionadas con trazado de rayos o las de cómputo puro y duro. Además de que al tener memoria unificada, la CPU tendrá más memoria disponible para las otras tareas que no tengan que ver con la GPU.

Vía: Tom's Hardware, Tom's Hardware (2).