Intel compró en 2016 a la empresa de inteligencia artificial Nervana, y es ahora cuando la compañía da información de los primeros productos que surgen de aquella inversión. Se trata de dos procesadores de redes neuronales (NPP) que tienen el nombre NNP-T y NNP-I y distintas orientaciones. El primero es para entrenamiento de redes neuronales mientras que el segundo está pensado para inferencias, y de ahí no se les puede sacar.

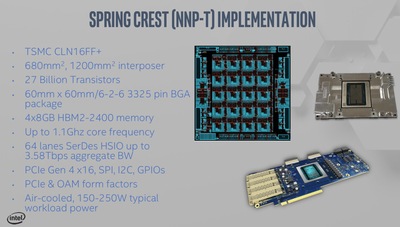

Son por tanto procesadores de propósito específico, si bien usan procesos de fabricación distintos. El NNP-T está fabricado por TSMC a 16 nm mientras que el NNP-I está fabricado por Intel a 10 nm.

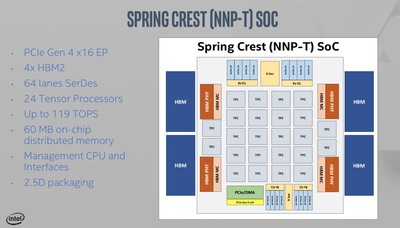

El NNP-T es un procesador con conectividad PCIe 4.0 ×16 e incluye 32 GB de memoria HBM2 en cuatro chips de 8 GB cada uno. Incluye un total de 24 procesadores tensoriales y es capaz de una potencia de cálculo de 119 TOPS. El chips principal tiene un tamaño de 680 mm2, mientras que el intermediador que une este chip con los de HBM2 tiene un tamaño de 1200 mm2. El procesador está introducido en un empaquetado de 60 × 60 mm, funcionando los núcleos a 1.1 GHz. La arquitectura mostrada por Intel se llama Spring Crest.

Implementa un conjunto de instrucciones basado en tensores, siendo un tensor una unidad algebraica muy usada en inteligencia artificial con sus propias características computacionales que hace idóneo crear chips como este especialmente preparados para calcularlos. Cada una de los procesadores tensoriales, también llamados clúster de procesamiento tensorial (TPC), tienen su propia memoria y comunicación con el resto de procesadores.

Lo que permite en el fondo el diseño anunciado por Intel y que se puede ver en esta presentación en PDF es que puede llegar a un aprovechamiento de los recursos del 86 % a la hora de realizar las convoluciones con un coste energético significativamente menor a un procesador convencional.

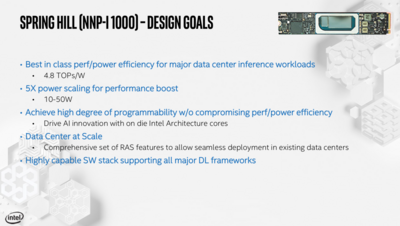

Por otro lado, la arquitectura Spring Hill usada en el NPP-I 1000 mostrado por la compañía conforma una pequeña unidad para inferencia de aprendizaje profundo en un práctico formato M.2 22110. Incluye un motor de computación de inferencias desarrollado por Intel, para cálculos en coma flotante de 8 y 16 bits, así como de enteros de 1, 2 y 4 bits. Usa para ello núcleos de tipo Ice Lake a 10 nm.

La idea de esta tarjeta es proporcionar una alta cantidad de inferencias por segundo a un consumo muy bajo que se sitúa en torno a los 4.8 TOPS por vatio, con la posibilidad de escalar el consumo entre los 10 y 50 W para mejorar aún más el rendimiento.

El desarrollo de este procesador se puede ver en la oportuna presentación en PDF.

Vía: Hot Hardware.