Una de las novedades de la arquitectura Turing es la inclusión de núcleos tensoriales para el cálculo por hardware de tensores, una entidad algebraica usada en el aprendizaje profundo. Aplicada a los gráficos, Nvidia promete el uso de una red neuronal entrenada como base del supermuestreo por aprendizaje profundo (DLSS), que es un método de suavizado de bordes potenciado por inteligencia artificial.

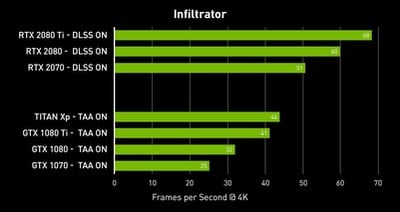

El resultado es que se pasa de hacer el suavizado mediante esos núcleos tensoriales en vez de los CUDA, lo que lleva a una mejora de rendimiento. Los datos que ha proporcionado Nvidia, como otros anteriores, demuestra el aumento de potencia respecto al uso del suavizado temporal (TAA) a una resolución de 4K en la prueba de rendimiento Infiltrator desarrollada por Epic Games. Aunque, como siempre digo, generalmente cuando se juega a 4K en un monitor típico de 27 pulgadas no se aplica ningún suavizado porque no tiene sentido por la densidad de píxeles que tienen esas pantallas a una distancia de uso típico de 50-70 cm.

Por lo tanto, lo que habría que comparar aquí no es una mejora de rendimiento con un suavizado aplicado a 4K que nadie que juegue a esa resolución debería usar, el TAA, sino si hay una mejora visual entre tener activado DLSS a 4K en el monitor típico de 27 pulgadas y no tenerlo.

Que es por lo que sigo criticando la falta de contenido para RTX, porque no se sabe empíricamente si las GeForce RTX proporcionan o no una mejora visual, y solo se puede uno fiar de la palabra de Nvidia. Que obviamente, sí que la introducirá por el trazado de rayos, pero no se sabe si con pérdida de rendimiento, o tantas otras cosas que no se saben del uso real de RTX. Y más cuando te vende Nvidia —o más bien sus socios fabricantes de tarjetas gráficas— una RTX 2080 bastante más cara que una GTX 1080 Ti que no dista mucho de potencia.

Como postre, una breve demo del uso del trazado de rayos en tiempo real para recrear la llegada a la Luna.

Vía: TechPowerUp.