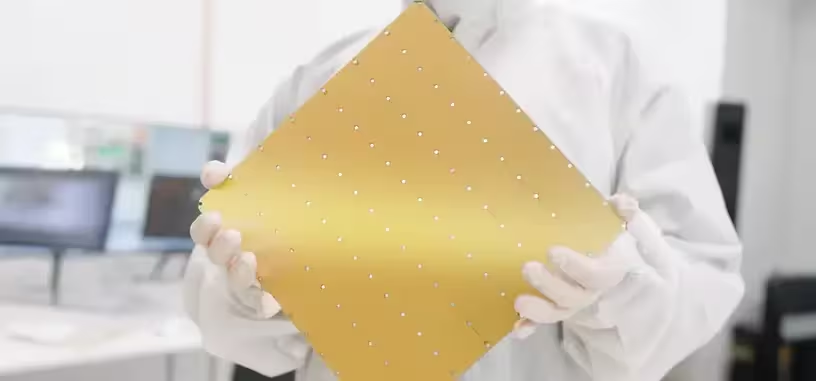

Cerebras es una de las muchas empresas que están metidas en el desarrollo de chips específicos de inteligencia artificial, y lo hace con un procesador a nivel de oblea. O sea, el nuevo procesador WSE-3, como los anteriores, ocupa una oblea entera de 300 mm, la cual posteriormente se recorta lo sobrante y se deja un cuadrado que es el procesador en sí. En esta ocasión se incluyen 900 000 núcleos de procesamiento para IA, que no es una gran mejora frente a los 850 000 núcleos del WSE-2.

Donde están los cambios es a nivel de arquitectura, porque este procesador alcanza una potencia de 125 petaFLOPS, que es el equivalente a 62 aceleradoras H100 de NVIDIA. También mejora un poco la cantidad de SRAM que incluye la propia oblea, de 40 GB a 44 GB, en sus 4 billones de transistores. Puede usar además 1.5 TB, 12 TB o 1.2 PB de memoria externa. Un clúster de los WSE-3 puede contener hasta 2048 procesadores. El proceso litográfico usado para producirlo es uno de 5 nm de TSMC.

Con esos datos, es un procesador extraordinario para entrenamiento de inteligencias artificiales generativas porque puede entrenar grandes modelos de lenguaje de hasta un billón de parámetros. Según la compañía, lo hace tan fácil como uno de mil millones en una GPU. Es compatible con bibliotecas de IA comunes como TensorFlow o PyTorch 2.0. Para usar estos procesadores se precisan de servidores CS-3 y bastidores especiales.

Para conseguir producir la oblea entera, la arquitectura de Cerebras tiene núcleos redundantes a través de una red en malla. Si se detecta algún núcleo defectuoso, se deshabilita y puentea internamente para usar alguno redundantes, por lo que en la práctica son bastantes más de 900 000 núcleos los que incluye. La compañía tiene una larga lista de pedidos pendientes. Ahora mismo está iniciando la construcción de la supercomputadora Condor Galaxy 3 con 64 equipos CS-3.

Vía: Tom's Hardware.