NVIDIA quiere mantener su indiscutible liderato en el terreno de la inteligencia artificial con la nueva arquitectura Blackwell. El empujón de rendimiento en cómputo es más que notable en todos los terrenos, ya que va de triplicar el rendimiento en FP8 hasta multiplicar por seis la cantidad de parámetros que pueden tener los modelos de lenguaje que pueden entrenarse con el chip que está detrás de las aceleradoras B100 y B200, aunque esta última incluye dos chips B100.

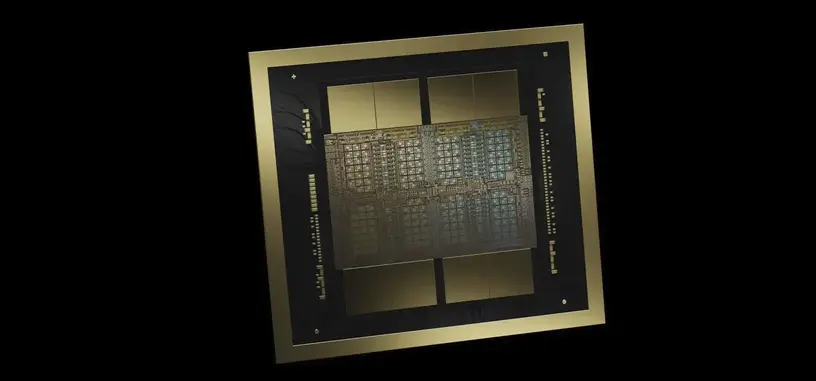

Ese chip va encapsulado con 192 GB de HBM3E, tiene 208 000 millones de transistores en dos chips y están fabricados en un proceso personalizado de 4 nm de TSMC al que NVIDIA llama 4NP. Como todos los procesos litográficos de 4 nm de TSMC, está basado en el de 5 nm. TSMC no creo nunca un proceso de 4 nm de la nada, a pesar de que el idiota @kopite7kimi esté desinformando al respecto dando a entender que hay un proceso de 4 nm de TSMC que no está basado en uno de 5 nm. Todas las litografías de 4 nm de TSMC están directamente basadas en la de 5 nm.

Los chips de HBM3E aportan un bus de memoria de 8192 bits, a razón de 1024 bits por chip, con lo que el ancho de banda se va a los 8 TB/s, en lugar de los 3.35 TB/s de la H100. El consumo de la aceleradora se sitúa en los 1000 W, frente a los 700 W de la H100. La compañía ha metido nuevos modos de procesamiento para hacerla aún más eficiente en el terreno de la computación de cargas de trabajo de inteligencia artificial. Esos son uno de FP6 con el que da 20 PFLOPS de potencia, un 150 % más que la H100, y otro de FP4 que alcanza los 40 PFLOPS, o un 400 % más.

La mayor parte de la mejora de este chip frente al H100 es debido principalmente a que son dos chips y no tanto a que haya mejoras sustanciales en la arquitectura Blackwell. Junto con el hecho de que se ha mantenido en el nodo de 4 nm de TSMC, se puede ver claramente que NVIDIA ha estimado que no necesita el nodo de 3 nm para maximizar aún más sus beneficios. Razón no le falta, porque no tiene competencia seria de momento, y más tras presentar esta solución.

La tarjeta en la que va la GPU es de formato SXM, con mejoras en otros terreno como el NVLink 5 que pasa a tener un ancho de banda de 1800 GB/s en lugar de 900 GB/s. La GPU también funciona como un único chip a pesar de que en la práctica son dos pastillas del mismo tipo pegadas con el proceso de encapsulado avanzado de TSMC, similar al usado por Apple para sus procesadores M Ultra, por lo que son una gran GPU CUDA unificada.

Vía: AnandTech.